Yapay zekanın yanıltıcılığı insan yanıltıcılığından daha kolay: Akıllı ifadeler, yalan, yanlış ve çarpıtma haber döngüsünü işletiyor.

Son on yılda interneti yanlış bilgiler sahte haberler doldurdu. 2018’de yapılan bir araştırma, Twitter platformunda yanlış, çarpıtma ve yalan haberlerin gerçek bilgilerden ve doğru haberlerden altı kat daha hızlı iletildiğini ortaya koydu.

Yalan haber döngüsü

Tarihsel olarak, akıllı haber çarkı dönmeye devam etmek için çok fazla çaba, zaman ve insan gerektiriyor. Bazı ülkelerdeki hükümet propaganda makineleri, internete gerçek görünen sahte içerik enjekte etmek için binlerce kişiyi istihdam ediyor. Ancak yeni bir çalışma, bu süreçlerin, halkı aldatmada daha büyük başarı elde etmek için insan sahte habercileri yapay zeka sistemleriyle değiştirebileceğini öne sürüyor.

Science dergisinde yayınlanan çalışmaya göre insanların, insanlar tarafından yazılan benzer gönderilere göre GPT3 (şu anda ChatGPT’ye güç veren büyük dil modelinin önceki sürümü) tarafından üretilen yanlış bilgilere inanma olasılığının daha yüksek olduğu bilgisine ulaştı.

Zürih Üniversitesi Biyoetik Enstitüsü’nden çalışmanın ortak yazarları Giovanni Spitale ve Federico Germani, GPT3’ün ‘web sitelerinde gördüğümüz aynı türden yanlış bilgileri daha hızlı, daha yüksek sıklıkta ve daha düşük maliyetle üretmek için’ bir silah olarak nasıl kullanılıp kullanılamayacağını analiz etti. Spitale ve Germani, çalışmalarına GPT3’ün iklim değişikliği, aşı güvenliği, evrim teorisi ve 5G gibi tartışmalı konular hakkında hem doğru hem de yanlış tweetler üretmesini sağlayacak komutlar tasarlayarak başladılar. Bu arada ikili, Twitter’da aynı konularda doğru ve yanıltıcı bilgiler içeren tweetler de araştırdı.

Şarku’l Avsat’ın Tribune Media’dan aktardığına göre araştırmacılar, araştırmaya katılan 700 kişiye gerçek insan tweetleri, sahte insan tweetleri ve doğru ve yanlış yapay zeka tweetlerini gösterdi. Daha sonra katılımcılardan tüm tweetlerde belirtilen doğru ve yanıltıcı bilgileri belirlemeleri istendi. Yüzde 92’si, insanlar tarafından yazılan yanlış bilgileri ve yapay zeka tarafından üretilen tweetlerdeki doğru bilgilerin doğruluğunu tespit etmeyi başardı. Buna karşılık yüzde 11’lik kesim, yapay zeka tarafından üretilen yanlış bilgilerin, insan yapımı içerikten yüzde 37,5 daha fazla gerçek olduğuna inanıyor.

Spitale, bu durumu ‘şaşırtıcı’ olarak nitelendirdi ve ‘ana odak noktamızın, insanların organik (yani insan yapımı) ile endüstriyel olanı ayırt edip edemediğine’ dikkat çekti.

Akıllı gramer

Spitale ve Germani, insanların yapay zeka tarafından üretilen yanlış bilgilere insanlar tarafından yazılanlardan daha fazla inanma eğilimini açıklamak için bilimsel bir neden bulamadı. Ancak bunun yapay zeka araçlarının cümleleri ustaca formüle etme biçimiyle bir ilgisi olduğuna inanıyor. Bu çerçevede Spitale, “Bir tweetin tartışmacı biçimi, yapay zeka tarafından oluşturulduğunda doğru veya yanıltıcı olsa da aynı görünüyor” dedi. Çalışma katılımcıları ayrıca, doğru yapay zeka tweetinin doğruluğunu insan tweetlerinden yüzde 72 daha kolay bir şekilde yüzde 84 doğrulamayı başardı.

Katılımcılar, yapay zeka tarafından üretilen yanlış bilgileri insanlardan daha hızlı okuyup onaylayabildiler. Çünkü muhtemelen daha net ve otomatik bir formatta yazılmıştı.

Yapay zekanın yardımıyla yaratılan ve yayılan dezenformasyonun ölçeğine baktığımızda, bu ikna gücü ve gerçekleşme hızı büyük bir sorun. Spitale, “Bu olgu, bağışıklama teorisi olarak biliniyor. Bu teori sayesinde biri, insanları yanıltıcı bilgilere maruz bırakan ve yanlış bilgiyi tespit etme becerilerine olan güvenlerinin arttığı bir bağlam yaratır. Yapay zeka içeriğini tanımada da aynı sonucu görmeyi umuyordum. Ama gördüğümüz tam tersiydi, yani yanlış bilgilendirme karşısında yapay zekanın ürünlerini belirlemeye olan güven kayboluyor” ifadelerini kullandı. İki araştırmacı, internetteki yapay zeka içeriğinin yaygınlığından dolayı çalışmalarının sonuçlarının endişe verici olduğunu belirtiyor.

İnsanların ‘belirli insanları akıllarından uzaklaştırmak ve kendi ağlarına dahil etmek için tasarlanmış’ dezenformasyon yaratabileceği fikri, yayılan bu yalan haberlerin uzun zamandır yapmaya çalıştığı bir şey.

Spitale, insanların bir yapay zeka silahlanma yarışına dahil olması fikri karşısında endişeli. Öyle ki şirketler, daha güçlü ve daha ikna edici dil modelleri geliştirmede birbirlerini geçmeye çalışıyor. Bu, müşterileri aldatmada daha etkili içerik üretmeye çalışılacağı anlamına geliyor. Spitale’nin araştırmasının yalnızca yazılı sözcüklere odaklandığını, üretken yapay zekanın ise görseller, videolar ve işitsel materyaller oluşturmada her an daha sofistike hale geldiğini unutmamamız gerekiyor. Bu da dezenformasyon riskini katlanarak artıracak.

Spitale, yapay zeka konusunda son derece iyimser, ancak aynı zamanda yönetişim fırsatını kaçıracağımız konusunda da korkuyor. Son olarak “Yapay zekayı düzenlemek için gereken hızda hareket etmiyoruz. Sanırım geri dönülmez bir noktaya ulaşıyoruz. Bu teknoloji çok hızlı gelişiyor” dedi.

Şarku'l Avsat haber Ajansı

Gaz tedarikini 'çeşitlendirmek' için Amerikan ExxonMobil şirketiyle görüşüyor

Gaz tedarikini 'çeşitlendirmek' için Amerikan ExxonMobil şirketiyle görüşüyor Cumhurbaşkanı Başdanışmanı Mehmet Uçum, nasıl bir "Anayasa değişikliği" istediklerini açıkladı

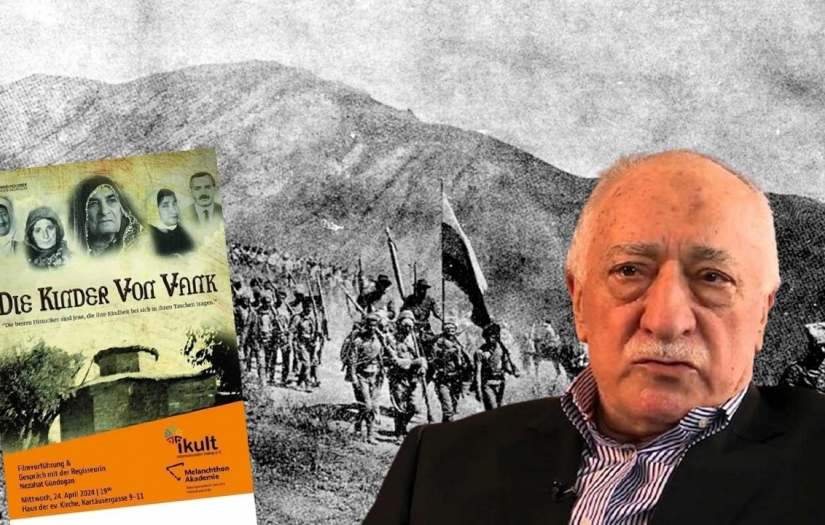

Cumhurbaşkanı Başdanışmanı Mehmet Uçum, nasıl bir "Anayasa değişikliği" istediklerini açıkladı FETÖ rahat durmuyor... Almanya'da da fitne peşindeler

FETÖ rahat durmuyor... Almanya'da da fitne peşindeler 59. İstanbul Yarı Maratonu nedeniyle bazı güzergahlar trafiğe kapatıldı

59. İstanbul Yarı Maratonu nedeniyle bazı güzergahlar trafiğe kapatıldı İsrail polisi Gazze'ye yardım götüren hahamları gözaltına aldı

İsrail polisi Gazze'ye yardım götüren hahamları gözaltına aldı 21. yüzyılın yeni süper gücü olma hedefindeki Hindistan'ın güçlü ve zayıf noktaları neler?

21. yüzyılın yeni süper gücü olma hedefindeki Hindistan'ın güçlü ve zayıf noktaları neler? Beyaz Saray'ın Gazze politikasını protesto eden ABD'li yetkili istifa etti

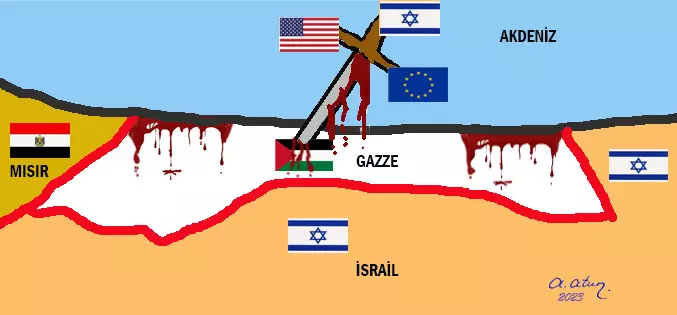

Beyaz Saray'ın Gazze politikasını protesto eden ABD'li yetkili istifa etti Erdoğan: İsrail'le ilişkilerimizi kestik, kesiyoruz

Erdoğan: İsrail'le ilişkilerimizi kestik, kesiyoruz Prof. Dr. İBRAHİM ORTAŞ yazdı: "Ülkemizin Üzerine Bocalanan Çöl Tozları Yararlı mı, Zararlı mı?.."

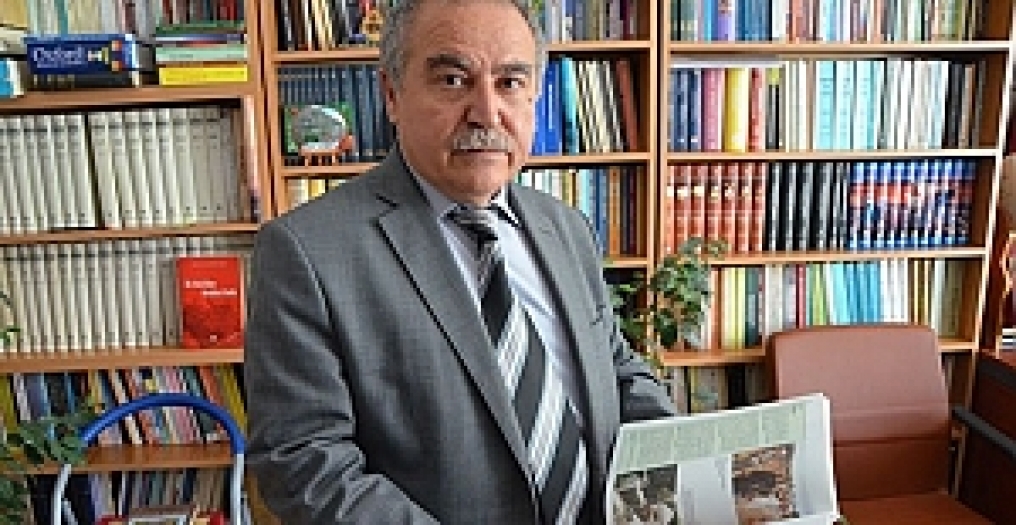

Prof. Dr. İBRAHİM ORTAŞ yazdı: "Ülkemizin Üzerine Bocalanan Çöl Tozları Yararlı mı, Zararlı mı?.." Prof. Dr. HİLMİ ÖZDEN yazdı: "Ermeni Gailesi Ve Tarihin Şahitliği"

Prof. Dr. HİLMİ ÖZDEN yazdı: "Ermeni Gailesi Ve Tarihin Şahitliği" ÖZKAN GÜNAL yazdı: "Tevhit Ruhtur? -2-"

ÖZKAN GÜNAL yazdı: "Tevhit Ruhtur? -2-" MÜJDAT KAYAYERLİ yazdı: "Hep Beraber 'BİZ' Olmalıyız.."

MÜJDAT KAYAYERLİ yazdı: "Hep Beraber 'BİZ' Olmalıyız.." Şair HİLMİ ÖZDEN yazdı: "Ey Türk Kızı (Oğlu) Tarih Kahırla Dolu.."

Şair HİLMİ ÖZDEN yazdı: "Ey Türk Kızı (Oğlu) Tarih Kahırla Dolu.." Şair ŞERİFE KÖKSAL BADISABA yazdı: "Kış mı Oldum.."

Şair ŞERİFE KÖKSAL BADISABA yazdı: "Kış mı Oldum.." Şair DERMANİ yazdı: "Senin Boynun Devrilsin.."

Şair DERMANİ yazdı: "Senin Boynun Devrilsin.." ABD'de Türk öğrenci Mükemmellik Ödülü'ne lâyık görüldü

ABD'de Türk öğrenci Mükemmellik Ödülü'ne lâyık görüldü Bakan Işıkhan'dan Asgari Ücretle İlgili Açıklama: Zam Yapılacak mı?

Bakan Işıkhan'dan Asgari Ücretle İlgili Açıklama: Zam Yapılacak mı? Lokanta ve kafeler ile müşterilerine kötü haber: KDV oranları yükseltildi

Lokanta ve kafeler ile müşterilerine kötü haber: KDV oranları yükseltildi Saniyeler içinde şarj olabilen batarya üretildi

Saniyeler içinde şarj olabilen batarya üretildi Kredi kartı Limitleri Değiştiriliyor

Kredi kartı Limitleri Değiştiriliyor Gençlerde kansere yakalanma oranları artıyor

Gençlerde kansere yakalanma oranları artıyor Kadın doktorların tedavi ettiği hastaların "ölme olasılığı daha düşük"

Kadın doktorların tedavi ettiği hastaların "ölme olasılığı daha düşük" Karakter gelişimine yönelik yeni araştırma: Anne ve babadan az etkileniyor

Karakter gelişimine yönelik yeni araştırma: Anne ve babadan az etkileniyor Yüz Ve Kollarınız Şişiyorsa Dikkat! Timoma Belirtisi Olabilir…

Yüz Ve Kollarınız Şişiyorsa Dikkat! Timoma Belirtisi Olabilir… Buse Naz Çakıroğlu üst üste 3. kez Avrupa şampiyonu

Buse Naz Çakıroğlu üst üste 3. kez Avrupa şampiyonu Süper Lig: Fenerbahçe 2-1 Beşiktaş

Süper Lig: Fenerbahçe 2-1 Beşiktaş Milli boksörlerimiz Avrupa'da finalde

Milli boksörlerimiz Avrupa'da finalde Miniklerin kupa ve madalya sevinçleri

Miniklerin kupa ve madalya sevinçleri Erzincan'ın Tercan ilçesi merkezli 4,1 büyüklüğünde deprem!

Erzincan'ın Tercan ilçesi merkezli 4,1 büyüklüğünde deprem! Sağlık Bakanlığı'na yıl sonuna kadar 36 bin sağlık personeli alınacak

Sağlık Bakanlığı'na yıl sonuna kadar 36 bin sağlık personeli alınacak Ankara'da Geleneksel "Trabzon Tanıtım Günleri" başladı

Ankara'da Geleneksel "Trabzon Tanıtım Günleri" başladı Merkez Bankası'nca, Kur Korumalı Mevduat'tan TL mevduata geçişin desteklenmesi için yeni bir müdahale

Merkez Bankası'nca, Kur Korumalı Mevduat'tan TL mevduata geçişin desteklenmesi için yeni bir müdahale

Nimet Çoban'dan Günün Kareleri..14

Nimet Çoban'dan Günün Kareleri..14

Nimet Çoban'dan Günün Kareleri..12

Nimet Çoban'dan Günün Kareleri..12

Nimet Çoban'dan Günün Kareleri..11

Nimet Çoban'dan Günün Kareleri..11

Nimet Çoban'dan Günün Kareleri..10

Nimet Çoban'dan Günün Kareleri..10